AI Act już działa – zaczęły obowiązywać pierwsze przepisy!

Już są! Pierwsze przepisy Aktu w sprawie sztucznej inteligencji (AI Act) zaczęły obowiązywać. Zgodnie z art. 113 lit. a AI Act, od wczoraj – 2 lutego 2025 r. stosuje się rozdziały I i II rozporządzenia. Oznacza to, że wszystkie podmioty określone w art. 2 ust. 1 AI Act są zobowiązane z jednej strony do rozwoju kompetencji w zakresie AI, z drugiej zaś do przestrzegania nowych ograniczeń dotyczących niektórych praktyk związanych ze sztuczną inteligencją.

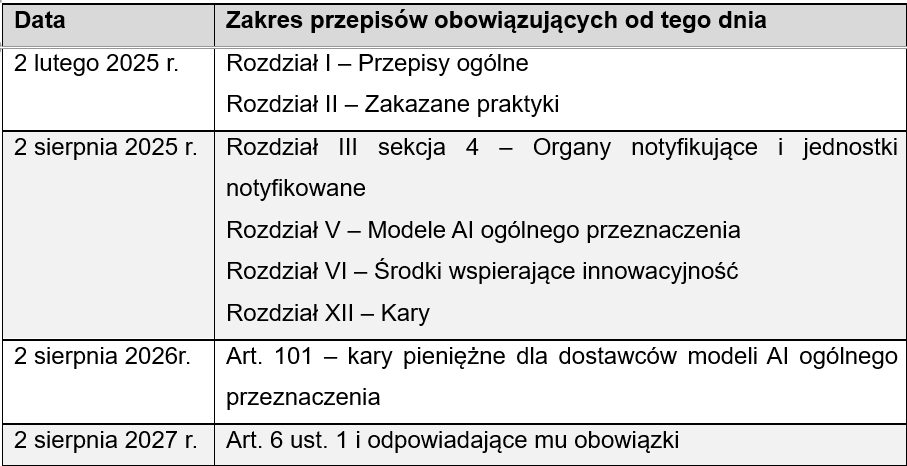

Stopniowe wdrażanie AI Act – przypomnienie kluczowych terminów

Dostosowanie się do nowych regulacji prawnych dotyczących sztucznej inteligencji wymaga czasu. Dlatego unijny prawodawca zdecydował się na stopniowe wprowadzanie przepisów AI Act.

Zgodnie z art. 113 AI Act, ogólna zasada stanowi, że:

- rozporządzenie weszło w życie → 2 sierpnia 2024 r.

- zacznie obowiązywać w zdecydowanej większości → 2 sierpnia 2026 r.

- zacznie obowiązywać w pełni → 2 sierpnia 2027 r.

Szczegółowa tabela rozpoczęcia stosowania poszczególnych przepisów AI Act.

Oznacza to, że od 2 lutego 2025 r. obowiązują Rozdziały I i II (art. 1 – 5 AI Act), które wprowadzają dwa kluczowe wymogi:

- rozwój kompetencji w zakresie AI,

- zakaz wprowadzania do obrotu/oddawania do użytku i wykorzystania niektórych systemów AI.

Czym są kompetencje w zakresie AI?

Wymóg zapewnienia kompetencji w zakresie sztucznej inteligencji, określony w art. 4 AI Act, to interesujące i istotne rozwiązanie legislacyjne. Jego celem jest realizacja założeń wskazanych w motywie 1 AI Act, a więc w szczególności upowszechnianie godnej zaufania sztucznej inteligencji oraz ochrony przed jej szkodliwymi skutkami.

Przepis ten nakłada na dostawców i podmioty stosujące systemy AI obowiązek podejmowania działań mających na celu zapewnienie odpowiedniego poziomu kompetencji wśród personelu oraz innych osób odpowiedzialnych za działanie i wykorzystanie systemów AI w ich imieniu. Przy wdrażaniu tego obowiązku należy uwzględnić wykształcenie i doświadczenie personelu, a także kontekst w jakim systemy AI będą stosowane.

Choć regulacja nie precyzuje, w jaki dokładnie sposób wymóg ten powinien być realizowany, jej treść sugeruje, że kluczowe będzie proaktywne podejście dostawców i podmiotów stosującego systemy AI. W praktyce oznacza to konieczność organizowania i zapewniania dostępu do różnego rodzaju szkoleń, warsztatów i kursów dotyczących sztucznej inteligencji.

Zakazane praktyki w zakresie AI – czyli jakie systemy AI są już nielegalne?

Zakazane praktyki w zakresie AI odnoszą się do podejmowania trzech działań:

- wprowadzania do obrotu oznaczającego udostępniania po raz pierwszy systemu AI lub modelu AI ogólnego przeznaczenia,

- oddawania do użytku oznaczającego dostarczania systemu AI do pierwszego użycia bezpośrednio podmiotowi stosującemu lub do użycia własnego, a także

- wykorzystania systemu AI.

W tym kontekście zakazane są systemy AI, które:

- stosują techniki podprogowe[1] będące poza świadomością danej osoby lub techniki manipulacyjne lub celowo wprowadzające w błąd

System AI będzie traktowany jako nielegalny, gdy wskutek jego zastosowania dojdzie do znacznej zmiany zachowania danej osoby lub grupy osób poprzez ograniczenie świadomości podejmowanych decyzji. Zawsze jednak taka sytuacja będzie musiała być rozpatrywana z perspektywy spowodowania u takiej osoby poważnej szkody.

Przykład zakazanego systemu: narzędzie marketingowe, stanowiące system sztucznej inteligencji, stosowane w centrum handlowym, które w subtelny sposób będzie zachęcać klientów do dokonywania określonych zakupów, a tym samym zwiększać sprzedaż danego produktu[2].

- wykorzystują słabość danej osoby lub grupy osób ze względu na wiek, niepełnosprawność, szczególną sytuację społeczną lub ekonomiczną

Celem takich systemów AI musi być dokonanie znacznej zmiany zachowania danej osoby, w sposób który wyrządzi lub z uzasadnionym prawdopodobieństwem wyrządzi względem nich poważną szkodę.

Przykład zakazanego systemu: system zarządzający finansami osoby z niepełnosprawnością prowadzący do zaciągnięcia zobowiązań finansowych przez tę osobę[3].

- dokonują oceny lub klasyfikacji osób

Zagadnienie to dotyczy systemów AI dokonujących tzw. scoringu, a więc takich algorytmów, które przez określony czas dokonują oceny osób na podstawie ich zachowania społecznego lub znanych, wywnioskowanych, bądź przewidywalnych cech osobistych lub osobowości. W tej kwestii podkreślić należy, że tylko systemy scoringowe są zakazane, gdy prowadzą do przynajmniej jednego z następujących skutków:

-

- krzywdzącego lub niekorzystnego traktowania osób w kontekstach społecznych, które nie są związane z kontekstami, w których pierwotnie wygenerowano lub zebrano dane,

- krzywdzącego lub niekorzystnego traktowania, które jest nieuzasadnione lub nieproporcjonalne do ich zachowania społecznego lub jego wagi.

Przykład zakazanego systemu: wszelkiego rodzaju systemy monitorujące i oceniające zachowania społeczne i na tej podstawie promujące pewne zachowania, np. poprzez przyznanie określonych punktów[4].

- przeprowadzają ocenę ryzyka w odniesieniu do osób fizycznych

W tym kontekście mowa o systemach AI określających ryzyko popełniania przestępstw, wyłącznie na podstawie profilowania lub oceny cech danej osoby. Z tego obszaru wyłączono jednak systemy, które ze wsparciem człowieka dokonują oceny udziału danej osoby w działalności przestępczej, która oparta jest już na obiektywnych i weryfikowalnych faktach.

- tworzą i rozbudowują bazy danych służące rozpoznawaniu twarzy

Dotyczy to w szczególności systemów AI, które dokonują tzw. nieukierunkowanego scrapingu wizerunków twarzy, w szczególności z powszechnie dostępnych źródeł cyfrowych.

Przykład zakazanego systemu: system AI, który skanuje profile użytkowników w social media celem zebrania maksymalnie dużej ilości wizerunków twarzy.

- wyciągają wnioski na temat emocji osób

Działalność takich systemów dotyczyć będzie przede wszystkim miejsc pracy i instytucji edukacyjnych (szkół, uczelni wyższych). Zakaz ten nie będzie miał jednak charakteru absolutnego. Systemy rozpoznające emocje będą mogły być wprowadzane, gdy ich celem będzie zapewnienie bezpieczeństwa lub są wprowadzane ze względów medycznych.

Przykład zakazanego systemu: zakazane będą systemy AI stosowane w samochodach ciężarowych do rozpoznawania stopnia skupienia „zawodowego” kierowcy, chyba że ich celem będzie poprawa bezpieczeństwa, np. poprzez automatyczne włączenie dodatkowych asyst prowadzenia pojazdu.

- dokonują kategoryzacji biometrycznej

Dotyczy to systemów AI, które w oparciu o dane biometryczne osób są wstanie wydedukować lub wywnioskować informacje na temat rasy, poglądów politycznych czy orientacji seksualnej danej osoby. Zakaz ten nie dotyczy jednak etykietowania lub filtrowania zbiorów danych takich jak: obrazy ani kategoryzacji danych związanych ze ściganiem przestępstw.

- umożliwiają zdalną identyfikację biometryczną w czasie rzeczywistym w przestrzeni publicznej

Od ogólnej zasady zakazującej takich systemów przewidziano jednak trzy wyjątki.

-

- dotyczą one ukierunkowanego poszukiwania osób zaginionych lub będących ofiarami przestępstw: handlu ludźmi, uprowadzenia lub na tle seksualnym,

- zapobiegania zagrożeniu życia lub bezpieczeństwu fizycznemu osób, a także przewidywania zagrożeniu ataków terrorystycznych,

- lokalizowania lub identyfikowania osoby podejrzanej o popełnienie przestępstwa w celu prowadzenia postępowania przygotowawczego lub ścigania, albo wykonania kar w zakresie zbrodni określonych w załączniku II AIA.

Niemniej takie systemy mogą być wykorzystane jedynie do potwierdzenia tożsamości konkretnej osoby.

Podsumowanie

Od 2 lutego 2025 r. zaczęły obowiązywać pierwsze regulacje AI Act. Aktualnie stosowane przepisy (art. 1 – 5) obejmują:

- Obowiązek rozwoju kompetencji w zakresie AI – dostawcy i podmioty stosujące AI muszą zapewnić odpowiedni rozwoju kompetencji ich personelu w zakresie AI.

- Zakazane praktyki AI, które dotyczą systemów:

- stosujących techniki podprogowe i manipulacyjne,

- wykorzystujących słabości osób ze względu na wiek, niepełnosprawność, sytuacja społeczną/ekonomiczną,

- oceniających lub klasyfikujących osoby na podstawie zachowań społecznych,

- przewidujących ryzyko popełnienia przestępstw na podstawie profilowania,

- dokonujących nieautoryzowanego rozpoznawanie twarzy i kategoryzacji biometrycznej,

- identyfikujących dane biometryczne w czasie rzeczywistym (z wyjątkami).

Podkreślić należy, że to dopiero pierwszy etap wchodzenia w życie przepisów AI Act. Kolejne uregulowania zaczną być stosowane już za kolejne 6 miesięcy – 2 sierpnia 2025 r.

[1] Techniki podprogowe oznaczają oddziaływanie na mózg człowieka za pomocą informacji, które są przez niego spostrzegane (odbierane), jednak w sposób nieświadomy.

[2] Ministerstwo Cyfryzacji, Zakazane systemy AI, https://www.gov.pl/web/ai/zakazane-systemy-ai, (dostęp: 01.02.2024 r.).

[3] Tamże.

[4] Tamże.